| 損失函數 | 名稱 | 適用場景 |

|---|---|---|

| torch.nn.MSELoss() | 均方誤差損失 | 回歸 |

| torch.nn.L1Loss() | 平均絕對值誤差損失 | 回歸 |

| torch.nn.CrossEntropyLoss() | 交叉熵損失 | 多分類 |

| torch.nn.NLLLoss() | 負對數似然函數損失 | 多分類 |

| torch.nn.NLLLoss2d() | 圖片負對數似然函數損失 | 圖像分割 |

| torch.nn.KLDivLoss() | KL散度損失 | 回歸 |

| torch.nn.BCELoss() | 二分類交叉熵損失 | 二分類 |

| torch.nn.MarginRankingLoss() | 評價相似度的損失 | |

| torch.nn.MultiLabelMarginLoss() | 多標簽分類的損失 | 多標簽分類 |

| torch.nn.SmoothL1Loss() | 平滑的L1損失 | 回歸 |

| torch.nn.SoftMarginLoss() | 多標簽二分類問題的損失 |

多標簽二分類 |

torch.nn.CrossEntropyLoss(weight=None, # 1D張量,含n個元素,分別代表n類的權重,樣本不均衡時常用

size_average=None,

ignore_index=-100,

reduce=None,

reduction='mean' )

參數:

weight: 1D張量,含n個元素,分別代表n類的權重,樣本不均衡時常用, 默認為None.

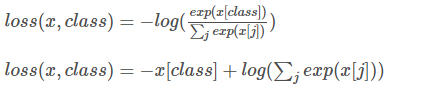

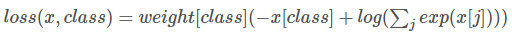

計算公式:

weight = None時:

weight ≠ None時:

輸入:

output: 網絡未加softmax的輸出

target: label值(0,1,2 不是one-hot)

代碼:

loss_func = CrossEntropyLoss(weight=torch.from_numpy(np.array([0.03,0.05,0.19,0.26,0.47])).float().to(device) ,size_average=True) loss = loss_func(output, target)

torch.nn.NLLLoss(weight=None,

size_average=None,

ignore_index=-100,

reduce=None,

reduction='mean')

輸入:

output: 網絡在logsoftmax后的輸出

target: label值(0,1,2 不是one-hot)

代碼:

loss_func = NLLLoss(weight=torch.from_numpy(np.array([0.03,0.05,0.19,0.26,0.47])).float().to(device) ,size_average=True) loss = loss_func(output, target)

總之, CrossEntropyLoss() = softmax + log + NLLLoss() = log_softmax + NLLLoss(), 具體等價應用如下:

####################---CrossEntropyLoss()---####################### loss_func = CrossEntropyLoss() loss = loss_func(output, target) ####################---Softmax+log+NLLLoss()---#################### self.softmax = nn.Softmax(dim = -1) x = self.softmax(x) output = torch.log(x) loss_func = NLLLoss() loss = loss_func(output, target) ####################---LogSoftmax+NLLLoss()---###################### self.log_softmax = nn.LogSoftmax(dim = -1) output = self.log_softmax(x) loss_func = NLLLoss() loss = loss_func(output, target)

補充:常用損失函數用法小結之Pytorch框架

在用深度學習做圖像處理的時候,常用到的損失函數無非有四五種,為了方便Pytorch使用者,所以簡要做以下總結

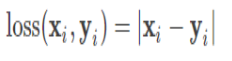

預測值與標簽值進行相差,然后取絕對值,根據實際應用場所,可以設置是否求和,求平均,公式可見下,Pytorch調用函數:nn.L1Loss

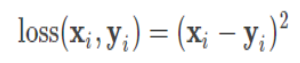

預測值與標簽值進行相差,然后取平方,根據實際應用場所,可以設置是否求和,求平均,公式可見下,Pytorch調用函數:nn.MSELoss

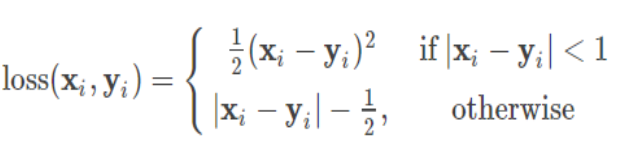

簡單來說就是L1和L2損失函數的綜合版本,結合了兩者的優點,公式可見下,Pytorch調用函數:nn.SmoothL1Loss

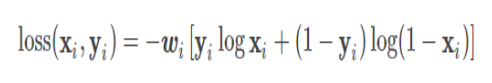

簡單來說,就是度量兩個概率分布間的差異性信息,在某一程度上也可以防止梯度學習過慢,公式可見下,Pytorch調用函數有兩個,一個是nn.BCELoss函數,用的時候要結合Sigmoid函數,另外一個是nn.BCEWithLogitsLoss()

也是度量兩個概率分布間的差異性信息,Pytorch調用函數也有兩個,一個是nn.NLLLoss,用的時候要結合log softmax處理,另外一個是nn.CrossEntropyLoss

以上為個人經驗,希望能給大家一個參考,也希望大家多多支持腳本之家。